Mengapa Perusahaan AI Harus Memberi Label Risiko Halusinasi dengan Jelas bagi Pengguna

Pendahuluan

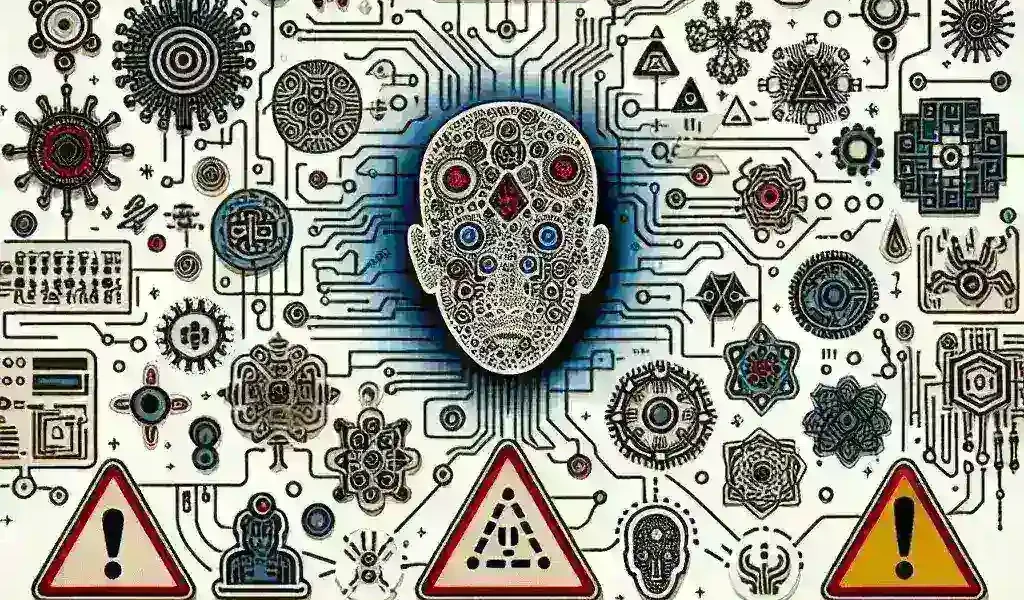

Dalam era digital saat ini, teknologi kecerdasan buatan (AI) semakin mendominasi berbagai aspek kehidupan. Dari layanan pelanggan hingga analisis data, AI menawarkan solusi yang efisien dan efektif. Namun, seiring dengan kemajuan ini, muncul tantangan baru yang perlu dihadapi, yaitu risiko halusinasi dalam AI. Artikel ini akan membahas mengapa perusahaan AI harus memberi label risiko halusinasi dengan jelas bagi pengguna.

Apa itu Halusinasi dalam AI?

Halusinasi dalam konteks AI merujuk pada situasi di mana model AI menghasilkan informasi yang salah atau tidak akurat yang tampak seolah-olah benar. Ini bisa terjadi akibat berbagai faktor, termasuk bias dalam data pelatihan, kesalahan algoritma, atau interpretasi yang salah terhadap pertanyaan pengguna.

Contoh Halusinasi dalam AI

Contoh nyata dari halusinasi dalam AI bisa dilihat pada sistem chatbot yang kadang-kadang memberikan jawaban yang tidak relevan atau bahkan menyesatkan. Misalnya, ketika ditanya tentang fakta sejarah, chatbot mungkin menjawab dengan informasi yang sepenuhnya salah, yang bisa membingungkan pengguna yang mencari jawaban yang akurat.

Kenapa Label Risiko Halusinasi Penting?

Memberi label risiko halusinasi adalah langkah penting bagi perusahaan AI untuk beberapa alasan:

- Transparansi: Pengguna perlu tahu bahwa meskipun AI dapat memberikan informasi yang berguna, ada juga risiko yang menyertainya. Dengan memberi label yang jelas, perusahaan menunjukkan komitmennya terhadap transparansi.

- Kepercayaan Pengguna: Ketika pengguna mengetahui bahwa ada kemungkinan AI dapat memberikan informasi yang salah, mereka lebih cenderung untuk menggunakan teknologi ini dengan hati-hati. Ini membantu membangun kepercayaan yang lebih besar antara pengguna dan produk AI.

- Pengurangan Risiko: Dengan memberi tahu pengguna tentang risiko halusinasi, perusahaan dapat membantu mengurangi potensi kerugian yang mungkin ditimbulkan akibat informasi yang salah.

Dampak Terhadap Pengguna

Risiko halusinasi dalam AI dapat memiliki dampak signifikan terhadap pengguna. Misalnya, dalam kasus layanan kesehatan, jika AI memberikan diagnosis yang salah, konsekuensinya bisa sangat serius. Pengguna harus dilengkapi dengan pengetahuan tentang kemungkinan risiko ini agar mereka dapat mengambil keputusan yang lebih baik.

Pengalaman Pengguna

Pengguna yang tidak diberi tahu tentang risiko halusinasi mungkin merasa sangat frustrasi ketika mendapatkan informasi yang salah. Ini dapat menyebabkan hilangnya kepercayaan tidak hanya pada produk AI tertentu, tetapi juga pada teknologi AI secara umum.

Langkah-Langkah Implementasi Label Risiko

Perusahaan AI dapat mengambil beberapa langkah untuk mengimplementasikan label risiko halusinasi:

- Pengujian dan Validasi: Melakukan pengujian menyeluruh untuk mengidentifikasi dan mengurangi risiko halusinasi sebelum produk diluncurkan.

- Pemberian Edukasi: Mengedukasi pengguna tentang cara menggunakan teknologi AI dengan bijak dan memahami batasan-batasan yang ada.

- Transparansi dalam Komunikasi: Menyediakan informasi yang jelas dan mudah dipahami tentang risiko-risiko yang mungkin dihadapi pengguna.

Studi Kasus: Keberhasilan dan Kegagalan

Terdapat banyak studi kasus yang menunjukkan pentingnya memberi label risiko halusinasi. Sebagai contoh, sebuah perusahaan teknologi besar yang meluncurkan asisten virtual yang diharapkan dapat membantu pengguna dalam berbagai tugas mengalami masalah ketika pengguna mengajukan pertanyaan yang tidak terduga. Tanpa label risiko halusinasi, banyak pengguna yang merasa bingung dan kehilangan kepercayaan terhadap produk tersebut.

Pelajaran yang Dapat Diambil

Penting bagi perusahaan lain untuk belajar dari pengalaman ini dan mengadopsi pendekatan yang lebih transparan dalam mengkomunikasikan risiko halusinasi kepada pengguna mereka.

Kesimpulan

Dalam dunia yang semakin bergantung pada kecerdasan buatan, penting bagi perusahaan AI untuk mengakui dan memberi label risiko halusinasi dengan jelas. Dengan melakukan ini, mereka tidak hanya melindungi pengguna mereka tetapi juga membangun kepercayaan yang lebih besar terhadap teknologi AI secara keseluruhan. Memastikan bahwa pengguna dilengkapi dengan pengetahuan yang tepat dan pemahaman tentang risiko yang ada adalah langkah penting menuju penggunaan AI yang lebih aman dan efektif di masa depan.

Tinggalkan Balasan